Speicher mit hoher Bandbreite - High Bandwidth Memory

| Computerspeicher und Datenspeichertypen |

|---|

| Flüchtig |

| Nicht flüchtig |

High Bandwidth Memory ( HBM ) ist eine Hochgeschwindigkeits- Computerspeicherschnittstelle für 3D-gestapelten synchronen dynamischen Direktzugriffsspeicher (SDRAM) ursprünglich von Samsung , AMD und SK Hynix . Es wird in Verbindung mit Hochleistungsgrafikbeschleuniger, Netzwerkgeräte, High-Performance Rechenzentrum AI verwendet ASICs und FPGAs und in einigen Supercomputern (wie der NEC SX-Aurora TSUBASA und Fujitsu A64FX ). Der erste HBM-Speicherchip wurde 2013 von SK Hynix produziert, und die ersten Geräte, die HBM verwendeten, waren die AMD Fiji- GPUs im Jahr 2015.

High Bandwidth Memory wurde im Oktober 2013 von JEDEC als Industriestandard übernommen. Die zweite Generation, HBM2 , wurde von JEDEC im Januar 2016 akzeptiert.

Technologie

HBM erreicht eine höhere Bandbreite bei geringerem Stromverbrauch in einem wesentlich kleineren Formfaktor als DDR4 oder GDDR5 . Dies wird durch Stapeln von bis zu acht DRAM- Chips und einem optionalen Basis-Chip erreicht, der Pufferschaltungen und Testlogik umfassen kann. Der Stack ist häufig über ein Substrat, beispielsweise einen Silizium- Interposer, mit dem Speichercontroller einer GPU oder CPU verbunden . Alternativ könnte der Speicherchip direkt auf dem CPU- oder GPU-Chip gestapelt werden. Innerhalb des Stapels sind die Chips durch Durchkontaktierungen durch Silizium (TSVs) und Mikrohöcker vertikal miteinander verbunden . Die HBM-Technologie ist im Prinzip ähnlich, jedoch nicht kompatibel mit der von Micron Technology entwickelten Schnittstelle Hybrid Memory Cube (HMC) .

Der HBM-Speicherbus ist im Vergleich zu anderen DRAM-Speichern wie DDR4 oder GDDR5 sehr breit. Ein HBM-Stack aus vier DRAM-Dies (4-Hi) hat zwei 256-Bit-Kanäle pro Die für insgesamt 8 Kanäle und eine Breite von insgesamt 1024 Bit. Eine Grafikkarte/GPU mit vier 4‑Hi HBM-Stacks hätte also einen Speicherbus mit einer Breite von 4096 Bit. Im Vergleich dazu beträgt die Busbreite von GDDR-Speichern 32 Bit, bei 16 Kanälen für eine Grafikkarte mit 512 Bit Speicherinterface. HBM unterstützt bis zu 4 GB pro Paket.

Die größere Anzahl von Verbindungen zum Speicher im Vergleich zu DDR4 oder GDDR5 erforderte eine neue Methode zum Verbinden des HBM-Speichers mit der GPU (oder einem anderen Prozessor). AMD und Nvidia haben beide speziell angefertigte Siliziumchips, sogenannte Interposer , verwendet, um den Speicher und die GPU zu verbinden. Dieser Interposer hat den zusätzlichen Vorteil, dass der Speicher und der Prozessor physisch nahe beieinander sein müssen, was die Speicherwege verringert. Da jedoch die Herstellung von Halbleiterbauelementen erheblich teurer ist als die Herstellung von Leiterplatten , erhöht dies die Kosten des Endprodukts.

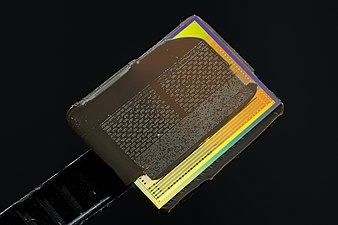

HBM-Speicher auf dem GPU-Paket einer AMD Radeon R9 Nano- Grafikkarte

Schnittstelle

Der HBM-DRAM ist über eine verteilte Schnittstelle eng mit dem Host-Rechenchip verbunden. Die Schnittstelle ist in unabhängige Kanäle unterteilt. Die Kanäle sind völlig unabhängig voneinander und nicht unbedingt synchron zueinander. Der HBM-DRAM verwendet eine Wide-Interface-Architektur, um einen Hochgeschwindigkeits- und Low-Power-Betrieb zu erreichen. Der HBM-DRAM verwendet einen 500-MHz- Differenztakt CK_t / CK_c (wobei das Suffix "_t" die "wahre" oder "positive" Komponente des Differenzpaars bezeichnet und "_c" für die "komplementäre" Komponente steht). Befehle werden an der steigenden Flanke von CK_t, CK_c registriert. Jede Kanalschnittstelle unterhält einen 128-Bit-Datenbus, der mit doppelter Datenrate (DDR) arbeitet. HBM unterstützt Übertragungsraten von 1 GT/s pro Pin (1 Bit übertragen), was eine Gesamtpaketbandbreite von 128 GB/s ergibt.

HBM2

Die zweite Generation des High Bandwidth Memory, HBM2, spezifiziert ebenfalls bis zu acht Dies pro Stack und verdoppelt die Pin-Transferraten auf bis zu 2 GT/s . Bei einem 1024-Bit breiten Zugriff kann HBM2 eine Speicherbandbreite von 256 GB/s pro Paket erreichen. Die HBM2-Spezifikation erlaubt bis zu 8 GB pro Paket. HBM2 wird als besonders nützlich für leistungskritische Verbraucheranwendungen wie Virtual Reality vorhergesagt .

Am 19. Januar 2016 kündigte Samsung eine frühe Massenproduktion von HBM2 mit bis zu 8 GB pro Stack an. SK Hynix kündigte außerdem die Verfügbarkeit von 4-GB-Stacks im August 2016 an.

Der HBM2-Interposer einer Radeon RX Vega 64 GPU, mit entfernten HBM-Dies; die GPU ist noch vorhanden

HBM2E

Ende 2018 kündigte JEDEC ein Update der HBM2-Spezifikation an, das für mehr Bandbreite und Kapazitäten sorgt. Bis zu 307 GB/s pro Stack (2,5 Tbit/s effektive Datenrate) werden nun in der offiziellen Spezifikation unterstützt, obwohl es bereits Produkte mit dieser Geschwindigkeit gab. Darüber hinaus wurde mit dem Update die Unterstützung für 12-Hi-Stacks (12 Dies) hinzugefügt, wodurch Kapazitäten von bis zu 24 GB pro Stapel möglich sind.

Am 20. März 2019 kündigte Samsung seinen Flashbolt HBM2E an, der mit acht Dies pro Stack, einer Transferrate von 3,2 GT/s und insgesamt 16 GB und 410 GB/s pro Stack ausgestattet ist.

Am 12. August 2019 kündigte SK Hynix seinen HBM2E an, der mit acht Dies pro Stack, einer Transferrate von 3,6 GT/s und insgesamt 16 GB und 460 GB/s pro Stack ausgestattet ist. Am 2. Juli 2020 gab SK Hynix bekannt, dass die Massenproduktion begonnen hat.

HBM3

Ende 2020 enthüllte Micron , dass der HBM2E-Standard aktualisiert werden würde, und gleichzeitig den nächsten Standard namens HBMnext (später in HBM3 umbenannt). Dies ist ein großer Generationssprung von HBM2 und dem Ersatz zu HBM2E. Dieser neue VRAM wird im vierten Quartal 2022 auf den Markt kommen. Dies wird wahrscheinlich eine neue Architektur einführen, wie die Namensgebung vermuten lässt.

Während die Architektur möglicherweise überarbeitet wird, deuten Lecks darauf hin, dass die Leistung ähnlich der des aktualisierten HBM2E-Standards ist. Dieser RAM wird wahrscheinlich hauptsächlich in Rechenzentrums- GPUs verwendet .

Mitte 2021 stellte SK Hynix einige Spezifikationen des HBM3-Standards mit 5,2 Gbit/s I/O-Geschwindigkeiten und einer Bandbreite von 665 GB/s pro Paket sowie 2,5D- und 3D-Lösungen mit bis zu 16 High vor.

HBM-PIM

Im Februar 2021 kündigte Samsung die Entwicklung von HBM mit Processing-in-Memory an. Dieser neue Speicher bringt KI-Computing-Fähigkeiten in den Speicher, um die Verarbeitung von Daten im großen Maßstab zu erhöhen. In jeder Speicherbank befindet sich eine DRAM-optimierte KI-Engine, um eine parallele Verarbeitung zu ermöglichen und die Datenbewegung zu minimieren. Samsung behauptet, dass dies die doppelte Systemleistung liefert und den Energieverbrauch um mehr als 70 % senkt, während keine Hardware- oder Softwareänderungen am Rest des Systems erforderlich sind.

Geschichte

Hintergrund

Die-Stacked- Speicher wurde ursprünglich in der Flash-Speicherindustrie kommerzialisiert . Toshiba stellte im April 2007 einen NAND-Flash- Speicherchip mit acht Stacked-Dies vor, gefolgt von Hynix Semiconductor, der im September 2007 einen NAND-Flash-Chip mit 24 Stacked-Dies vorstellte.

3D-Stacked Random Access Memory (RAM) mit Through-Silicon Via (TSV)-Technologie wurde von Elpida Memory kommerzialisiert , das im September 2009 den ersten 8- GB- DRAM- Chip (gestapelt mit vier DDR3- SDRAM- Chips ) entwickelte und im Juni auf den Markt brachte 2011. Im Jahr 2011 führte SK Hynix 16 GB DDR3-Speicher ( 40- nm- Klasse) mit TSV-Technologie ein, Samsung Electronics führte im September 3D-gestapelte 32- GB-DDR3-( 30- nm- Klasse) basierend auf TSV ein, und dann kündigten Samsung und Micron Technology TSV- basierte Hybrid Memory Cube (HMC)-Technologie im Oktober.

JEDEC veröffentlichte im Dezember 2011 nach mehrjähriger Arbeit erstmals den JESD229-Standard für Wide IO-Speicher, den Vorgänger von HBM mit vier 128-Bit-Kanälen mit Single-Data-Rate-Taktung. Im Oktober 2013 folgte der erste HBM-Standard JESD235.

Entwicklung

Die Entwicklung von High Bandwidth Memory begann 2008 bei AMD, um das Problem des ständig steigenden Stromverbrauchs und des Formfaktors des Computerspeichers zu lösen. In den nächsten Jahren entwickelte AMD mit einem Team unter der Leitung von Senior AMD Fellow Bryan Black Verfahren zur Lösung von Die-Stacking-Problemen. Um AMD bei der Verwirklichung ihrer HBM-Vision zu unterstützen, engagierten sie Partner aus der Speicherindustrie, insbesondere das koreanische Unternehmen SK Hynix , das bereits Erfahrung mit 3D-gestapelten Speicher hatte, sowie Partner aus der Interposer- Industrie (taiwanesisches Unternehmen UMC ) und der Verpackungsindustrie ( Amkor-Technologie und ASE ).

Die Entwicklung von HBM wurde 2013 abgeschlossen, als SK Hynix den ersten HBM-Speicherchip baute. HBM wurde im Oktober 2013 von JEDEC als Industriestandard JESD235 eingeführt , nach einem Vorschlag von AMD und SK Hynix im Jahr 2010. Die Großserienfertigung begann 2015 in einem Werk von Hynix in Icheon , Südkorea.

Die erste GPU, die HBM verwendet, war die AMD Fiji, die im Juni 2015 veröffentlicht wurde und die AMD Radeon R9 Fury X antreibt.

Im Januar 2016 begann Samsung Electronics mit der frühen Massenproduktion von HBM2. Im selben Monat wurde HBM2 von JEDEC als Standard JESD235a akzeptiert. Der erste GPU-Chip, der HBM2 verwendet, ist der Nvidia Tesla P100, der im April 2016 offiziell angekündigt wurde.

Im Juni 2016 veröffentlichte Intel eine Familie von Xeon Phi- Prozessoren mit 8 HCDRAM-Stacks, Microns Version von HBM. Auf der Hot Chips im August 2016 kündigten sowohl Samsung als auch Hynix eine neue Generation von HBM-Speichertechnologien an. Beide Unternehmen kündigten Hochleistungsprodukte an, von denen erwartet wird, dass sie eine höhere Dichte, größere Bandbreite und einen geringeren Stromverbrauch aufweisen. Samsung kündigte auch eine kostengünstigere Version von HBM an, die sich in der Entwicklung befindet, die auf Massenmärkte abzielt. Das Entfernen des Pufferchips und das Verringern der Anzahl der TSVs senkt die Kosten, allerdings auf Kosten einer verringerten Gesamtbandbreite (200 GB/s).

Siehe auch

- Gestapelter DRAM

- eDRAM

- Chip-Stack-Multi-Chip-Modul

- Hybrid Memory Cube : Stacked Memory-Standard von Micron Technology (2011)

Verweise

Externe Links

- High Bandwidth Memory (HBM) DRAM (JESD235) , JEDEC, Oktober 2013

- Lee, Dong Großbritannien; Kim, Kyung Whan; Kim, Kwan Weon; Kim, Hongjung; Kim, Ju Young; et al. (9.–13.02.2014). „Ein 1,2 V 8 Gb 8-Kanal 128 GB/s High-Bandwidth Memory (HBM) Stacked DRAM mit effektiven Microbump-I/O-Testmethoden mit 29-nm-Prozess und TSV“. 2014 IEEE International Solid-State Circuits Conference – Digest of Technical Papers . IEEE (veröffentlicht am 6. März 2014): 432–433. doi : 10.1109/ISSCC.2014.6757501 . ISBN 978-1-4799-0920-9. S2CID 40185587 .

- HBM vs HBM2 vs GDDR5 vs GDDR5X Speichervergleich